Slimme hardware maakt het trainen van neurale netwerken makkelijker

Onderzoekers van de TU/e, onder leiding van Yoeri van de Burgt en Marco Fattori, hebben een belangrijk probleem met betrekking tot neuromorfische chips opgelost. Het nieuwe onderzoek is gepubliceerd in Science Advances.

Grootschalige neurale netwerkmodellen vormen de basis van veel AI-gebaseerde technologieën zoals neuromorfische chips, die geïnspireerd zijn op het menselijk brein. Het trainen van deze netwerken kan omslachtig, tijdrovend en energie-inefficiënt zijn, omdat het model vaak eerst op een computer wordt getraind en vervolgens naar de chip wordt overgebracht. Dit beperkt de toepassing en efficiëntie van neuromorfische chips. TU/e-onderzoekers hebben dit probleem opgelost door een neuromorfisch apparaat te ontwikkelen dat on-chip-training kan uitvoeren, waardoor het overbodig is om getrainde modellen naar de chip over te brengen. Dit zou kunnen leiden tot efficiëntere AI-chips in de toekomst.

Heb je er wel eens over nagedacht hoe geweldig je brein eigenlijk is? Het is niet alleen een krachtige rekenmachine, maar ook snel, dynamisch, flexibel en zeer energiezuinig. Daar heb je maar geluk mee!

Het is de combinatie van deze eigenschappen die onderzoekers aan de TU/e, zoals Yoeri van de Burgt, inspireerde om de werking van hersenen na te bootsen in technologieën waar leren belangrijk is. Denk bijvoorbeeld aan AI-systemen in transport, communicatie en gezondheidszorg.

De neurale link

“In het hart van dergelijke AI-systemen vind je waarschijnlijk een neuraal netwerk”, zegt Van de Burgt - universitair hoofddocent aan de faculteit Mechanical Engineering van de TU/e.

Neurale netwerken zijn op de hersenen geïnspireerde computersoftwaremodellen. In het menselijk brein praten neuronen met andere neuronen via synapsen, en hoe meer twee neuronen met elkaar praten, hoe sterker de verbinding tussen hen wordt. In neurale netwerkmodellen - die uit knooppunten bestaan - wordt de sterkte van een verbinding tussen twee willekeurige knooppunten bepaald door een getal dat het gewicht wordt genoemd.

“Neurale netwerken kunnen helpen bij het oplossen van complexe problemen met grote hoeveelheden gegevens, maar naarmate de netwerken groter worden, brengen ze toenemende energiekosten en hardwarebeperkingen met zich mee”, zegt Van de Burgt. “Maar er is een veelbelovend hardwarematig alternatief: neuromorfische chips.”

Neuromorfisch addertje

Net als neurale netwerken zijn neuromorfische chips geïnspireerd op hoe de hersenen werken, maar in de chips wordt de imitatie naar een heel nieuw niveau getild. Wanneer in de hersenen de elektrische lading in een neuron verandert, kan het elektrische ladingen naar aangesloten neuronen sturen. Neuromorfische chips bootsen dit proces na.

“In een neuromorfische chip zitten memristors, oftewel memory resistors. Dit zijn circuit devices die kunnen 'onthouden' hoeveel elektrische lading er in het verleden doorheen is gestroomd”, zegt Van de Burgt. “En dit is precies wat nodig is voor een apparaat dat gemodelleerd is op hoe neuronen in de hersenen informatie opslaan en met elkaar praten.”

Maar er zit een neuromorfisch addertje onder het gras - en dat heeft te maken met de twee manieren waarop mensen hardware op basis van neuromorfische chips trainen. Bij de eerste manier wordt de training gedaan op een computer en worden de gewichten van het netwerk toegewezen aan de hardware van de chip. Het alternatief is om de training in-situ of op de hardware te doen, maar de huidige memristors moeten één voor één worden geprogrammeerd en vervolgens op fouten worden gecontroleerd. Dit is nodig omdat de meeste memristors stochastisch zijn en het onmogelijk is om het apparaat te updaten zonder het te controleren.

“Deze manieren zijn kostbaar in termen van tijd, energie en rekenkracht. Om de energie-efficiëntie van neuromorfische chips echt te benutten, moet de training direct op de neuromorfische chips worden gedaan”, zegt Van de Burgt.

Van idee naar realisatie

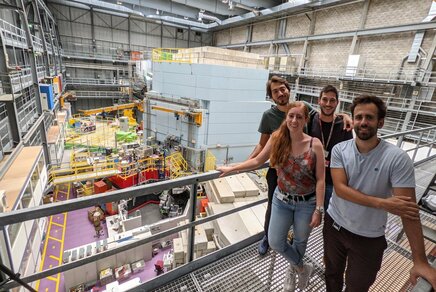

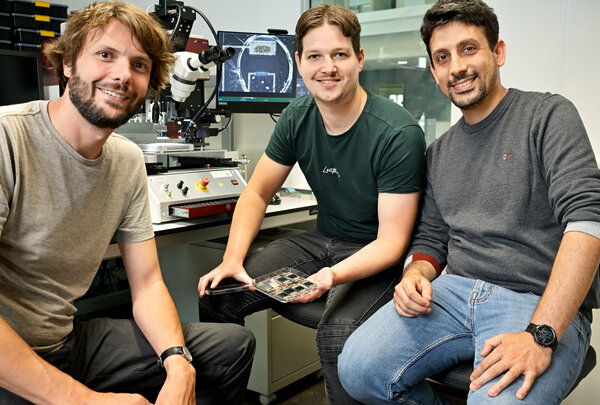

En dat is precies wat Van de Burgt en zijn medewerkers aan de TU/e hebben bereikt en waar zij over publiceerden in een nieuw artikel in Science Advances. “Dit was echt een teamprestatie, en allemaal geïnitieerd door co-first auteurs Tim Stevens en Eveline van Doremaele”, zegt Van de Burgt trots.

Het verhaal van het onderzoek is terug te voeren op het mastertraject van Tim Stevens. “Tijdens mijn masteronderzoek raakte ik geïnteresseerd in dit onderwerp. Nu hebben we laten zien dat het mogelijk is om training direct op de hardware uit te voeren, het is niet nodig om een getraind model over te zetten naar de chip. Deze ontdekking zou kunnen leiden tot efficiëntere chips voor AI-toepassingen”, zegt Stevens.

Van de Burgt, Stevens en Van Doremaele - die in 2023 promoveerde op een proefschrift over neuromorfische chips - hadden een beetje hulp nodig bij het ontwerpen van de hardware. Dus wendden ze zich tot Marco Fattori van de faculteit Electrical Engineering.

“Mijn groep hielp met aspecten die te maken hebben met het circuitontwerp van de chip”, zegt Fattori. “Het was geweldig om aan dit multidisciplinaire project te werken waarbij degenen die de chips bouwen samenwerken met degenen die aan de softwareaspecten werken.”

Voor Van de Burgt toonde het project ook aan dat goede ideeën van elke sport op de academische ladder kunnen komen. “Tim zag tijdens zijn masteronderzoek het potentieel om de eigenschappen van onze apparaten op een veel grotere schaal te benutten. Hiervan kunnen alle projecten iets leren.”

De training met twee lagen

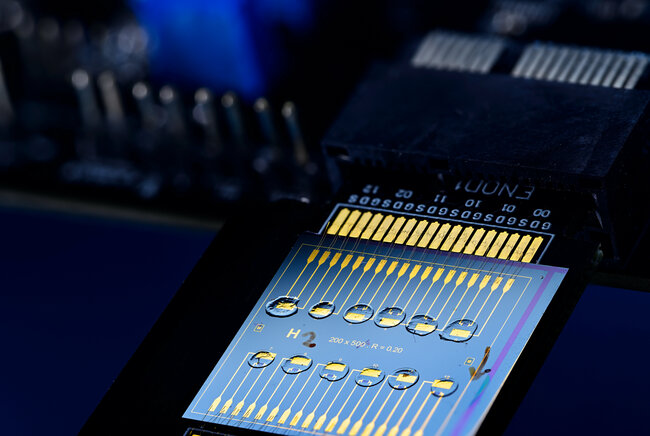

De grootste uitdaging voor de onderzoekers was het integreren van de belangrijkste componenten die nodig zijn voor on-chip training op een enkele neuromorfische chip. “Een belangrijke taak was bijvoorbeeld het integreren van de elektrochemische random-access memory (EC-RAM) componenten”, zegt Van de Burgt. “Dit zijn de componenten die de elektrische ladingopslag en het zenden van het signaal nabootsen, wat neuronen in de hersenen doen.”

De onderzoekers maakten een neuraal netwerk met twee lagen op basis van EC-RAM-componenten gemaakt van organische materialen. Zij testten de hardware met een evolutie van het veelgebruikte trainingsalgoritme backpropagation met gradient descent. “Het conventionele algoritme wordt vaak gebruikt om de nauwkeurigheid van neurale netwerken te verbeteren, maar dat is niet compatibel met onze hardware. Daarom bedachten we onze eigen versie”, zegt Stevens.

Nu AI op veel gebieden en in hoog tempo beslag legt op energiebronnen, is het bovendien verleidelijk voor veel applicaties – van ChatGPT tot apps voor weersvoorspellingen - om neurale netwerken te trainen op hardwarecomponenten voor een fractie van de energiekosten.

De toekomstige behoefte

Hoewel de onderzoekers hebben aangetoond dat de nieuwe trainingsaanpak werkt, is het de volgende logische stap om de neurale netwerken groter, gedurfder en beter te maken.

“We hebben laten zien dat dit werkt voor een klein netwerk met twee lagen”, zegt Van de Burgt. “Nu willen we de industrie en andere grote onderzoekslaboratoria erbij betrekken, zodat we veel grotere netwerken van hardware-apparaten kunnen bouwen en deze kunnen testen met levensechte dataproblemen.”

Met de volgende stap kunnen de onderzoekers aantonen dat deze systemen zeer efficiënt zijn in het trainen en uitvoeren van bruikbare neurale netwerken en AI-systemen. “We willen deze technologie graag in verschillende praktijkgevallen toepassen”, zegt Van de Burgt. “Mijn droom is dat dergelijke technologieën in de toekomst de norm worden in AI-toepassingen.”

Volledige details van de publicatie

“Hardware implementation of backpropagation using progressive gradient descent for in situ training of multilayer neural networks”, Eveline R. W. van Doremaele, Tim Stevens, Stijn Ringeling, Simone Spolaor, Marco Fattori, and Yoeri van de Burgt, Science Advances, (2024).

Eveline R. W. van Doremaele en Tim Stevens hebben in gelijke mate bijgedragen aan het onderzoek en worden beiden beschouwd als eerste auteur van het artikel.

Tim Stevens werkt momenteel als werktuigbouwkundig ingenieur bij MicroAlign, een bedrijf dat mede is opgericht door Marco Fattori.

Mediacontact

Meer over AI en Data Science

Het laatste nieuws